해당 내용은 Andrew Ng 교수님의 Machine Learning 강의(Coursera)를 정리한 내용입니다.

7주차 과제는 아래와 같다.

gaussianKernel.m - SVM을 위한 가우시안 커널 코드를 작성하면 된다.

dataset3Params.m - SVM의 파라미터 \(C, \sigma\)를 구하는 코드를 작성하면 된다.

processEmail.m - Email의 단어들을 순회하면서 해당하는 Voca List의 index번호를 찾아서 반환하는 코드를 작성한다.

emailFeatures.m - email로부터 feature를 추출해야 한다.

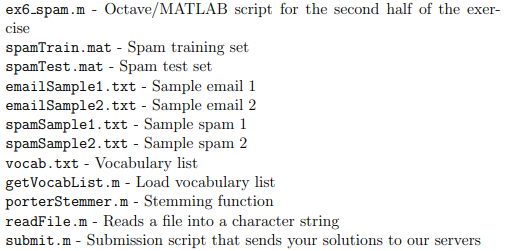

주어지는 함수들은 다음과 같다.

전체 코드는 아래 Github에서 확인할 수 있다.

https://github.com/junstar92/Coursera/tree/master/MachineLearning/ex6

[gaussianKernel.m]

가우시안 커널을 사용하는 Similarity Function으로 \(K(x_1, x_2) = exp(-\frac{\left \| x_1 - x_2 \right \|}{2\sigma^2})\)이고, 이 식을 코드로 나타내면 다음과 같다.

function sim = gaussianKernel(x1, x2, sigma)

%RBFKERNEL returns a radial basis function kernel between x1 and x2

% sim = gaussianKernel(x1, x2) returns a gaussian kernel between x1 and x2

% and returns the value in sim

% Ensure that x1 and x2 are column vectors

x1 = x1(:); x2 = x2(:);

% You need to return the following variables correctly.

sim = 0;

% ====================== YOUR CODE HERE ======================

% Instructions: Fill in this function to return the similarity between x1

% and x2 computed using a Gaussian kernel with bandwidth

% sigma

%

%

val = x1 - x2;

sim = exp(-sum((val.^2)) / (2 * sigma.^2));

% =============================================================

end

[dataset3Params.m]

코드를 작성하기 전에, SVM을 학습하기 위한 코드를 우선적으로 숙지하고 있어야한다. DataSet2를 통해서 가우시안 커널을 사용한 SVM을 학습했기 때문에, ex6.m의 Example Dataset 2 부분의 코드를 참조하였다.

svmTrain 함수를 사용해서 model을 학습한다. Parameter로 training example의 input \(x\), output \(y\), \(C\), 그리고 Similarity Function으로 가우시안 커널 함수를 사용한다. 그리고 svmPredict함수로 예측값을 얻는다. 이 함수의 파라미터는 우리가 학습한 model과 여기서 Cross Validation Set을 사용한다.

이 과제에서 주된 목적은 최적의 \(C\)와 \(\sigma\)를 찾는 것이다. 우리는 강의에서 최적의 Parameter를 찾을 때, Training Set을 통해서 여러 값의 파라미터를 사용해서 모델을 학습하고, 각 학습한 모델에 CV Set을 사용해서 Error가 가장 작은 파라미터를 선택한다고 배웠다. 따라서, 우리는 파라미터 값으로 0.01, 0.03, 0.1, 0.3, 1, 3, 10, 30을 사용해서 각 모델들을 학습하고 CV Set을 통해서 최적의 파라미터 값을 찾는다.

이 과제에서 Training Set으로 dataset3Params.m으로부터 추출한 (X, y)를 사용한다. 이 Training Set으로 svmTrain 함수로 SVM model을 학습하면 된다. 그리고 우리는 \(C, \sigma\) 두 가지의 파라미터로 모델을 학습해야하기 때문에, 이중 for문을 통해서 모든 case의 모델을 학습하고 각 case에서의 CV Error를 저장해둔다. 그리고 이중 for문을 빠져나와서 가장 작은 Error를 가지는 파라미터 \(C\)와 \(\sigma\)를 반환하면 된다.

코드는 아래와 같다.

function [C, sigma] = dataset3Params(X, y, Xval, yval)

%DATASET3PARAMS returns your choice of C and sigma for Part 3 of the exercise

%where you select the optimal (C, sigma) learning parameters to use for SVM

%with RBF kernel

% [C, sigma] = DATASET3PARAMS(X, y, Xval, yval) returns your choice of C and

% sigma. You should complete this function to return the optimal C and

% sigma based on a cross-validation set.

%

% You need to return the following variables correctly.

C = 1;

sigma = 0.3;

% ====================== YOUR CODE HERE ======================

% Instructions: Fill in this function to return the optimal C and sigma

% learning parameters found using the cross validation set.

% You can use svmPredict to predict the labels on the cross

% validation set. For example,

% predictions = svmPredict(model, Xval);

% will return the predictions on the cross validation set.

%

% Note: You can compute the prediction error using

% mean(double(predictions ~= yval))

%

C_val = [0.01 0.03 0.1 0.3 1 3 10 30];

sigma_val = [0.01 0.03 0.1 0.3 1 3 10 30];

for i = 1:length(C_val)

for j = 1:length(sigma_val)

model = svmTrain(X, y, C_val(i), @(x1, x2) gaussianKernel(x1, x2, sigma_val(j)));

prediction = svmPredict(model, Xval);

Error(i, j) = mean(double(prediction ~= yval));

endfor

endfor

min_Error = min(min(Error));

[i j] = find(Error == min_Error);

C = C_val(i);

sigma = sigma_val(j);

% =========================================================================

end

[processEmail.m]

과제 코드가 길어서 약간 당황했지만... 문제를 읽어보면 꽤나 간단하다. 제공되는 Voca 리스트에서 Email에서 등장한 단어를 찾아서 제공된 Voca 리스트의 index들을 저장해서 반환한다.

Email 내용을 소문자로 다 바꾸고, 숫자 등등을 다 지우는 과정을 거치고..

이제 while ~isempty(email_contents) 반복문 안에서 Email 단어와 일치하는 Voca 리스트의 Index를 저장하면 된다.

단어가 일치하는지 확인하는 것은 strcmp 함수를 사용하면 된다. 작성한 코드는 100~101 Line이다.

function word_indices = processEmail(email_contents)

%PROCESSEMAIL preprocesses a the body of an email and

%returns a list of word_indices

% word_indices = PROCESSEMAIL(email_contents) preprocesses

% the body of an email and returns a list of indices of the

% words contained in the email.

%

% Load Vocabulary

vocabList = getVocabList();

% Init return value

word_indices = [];

% ========================== Preprocess Email ===========================

% Find the Headers ( \n\n and remove )

% Uncomment the following lines if you are working with raw emails with the

% full headers

% hdrstart = strfind(email_contents, ([char(10) char(10)]));

% email_contents = email_contents(hdrstart(1):end);

% Lower case

email_contents = lower(email_contents);

% Strip all HTML

% Looks for any expression that starts with < and ends with > and replace

% and does not have any < or > in the tag it with a space

email_contents = regexprep(email_contents, '<[^<>]+>', ' ');

% Handle Numbers

% Look for one or more characters between 0-9

email_contents = regexprep(email_contents, '[0-9]+', 'number');

% Handle URLS

% Look for strings starting with http:// or https://

email_contents = regexprep(email_contents, ...

'(http|https)://[^\s]*', 'httpaddr');

% Handle Email Addresses

% Look for strings with @ in the middle

email_contents = regexprep(email_contents, '[^\s]+@[^\s]+', 'emailaddr');

% Handle $ sign

email_contents = regexprep(email_contents, '[$]+', 'dollar');

% ========================== Tokenize Email ===========================

% Output the email to screen as well

fprintf('\n==== Processed Email ====\n\n');

% Process file

l = 0;

while ~isempty(email_contents)

% Tokenize and also get rid of any punctuation

[str, email_contents] = ...

strtok(email_contents, ...

[' @$/#.-:&*+=[]?!(){},''">_<;%' char(10) char(13)]);

% Remove any non alphanumeric characters

str = regexprep(str, '[^a-zA-Z0-9]', '');

% Stem the word

% (the porterStemmer sometimes has issues, so we use a try catch block)

try str = porterStemmer(strtrim(str));

catch str = ''; continue;

end;

% Skip the word if it is too short

if length(str) < 1

continue;

end

% Look up the word in the dictionary and add to word_indices if

% found

% ====================== YOUR CODE HERE ======================

% Instructions: Fill in this function to add the index of str to

% word_indices if it is in the vocabulary. At this point

% of the code, you have a stemmed word from the email in

% the variable str. You should look up str in the

% vocabulary list (vocabList). If a match exists, you

% should add the index of the word to the word_indices

% vector. Concretely, if str = 'action', then you should

% look up the vocabulary list to find where in vocabList

% 'action' appears. For example, if vocabList{18} =

% 'action', then, you should add 18 to the word_indices

% vector (e.g., word_indices = [word_indices ; 18]; ).

%

% Note: vocabList{idx} returns a the word with index idx in the

% vocabulary list.

%

% Note: You can use strcmp(str1, str2) to compare two strings (str1 and

% str2). It will return 1 only if the two strings are equivalent.

%

idx = find(strcmp(vocabList, str) == 1);

word_indices = [word_indices; idx];

% =============================================================

% Print to screen, ensuring that the output lines are not too long

if (l + length(str) + 1) > 78

fprintf('\n');

l = 0;

end

fprintf('%s ', str);

l = l + length(str) + 1;

end

% Print footer

fprintf('\n\n=========================\n');

end

[emailFeatures.m]

feature vector를 반환하는 함수이다. 여기서 Voca의 개수는 1899로 정해져있고 우리는 이미 위에서 Email에 등장하는 단어와 동일한 Voca 리스트의 index를 저장했다. 그리고 단어가 등장하는 index에 해당하는 feature \(x_i\)만 1로 설정해주면 된다.

function x = emailFeatures(word_indices)

%EMAILFEATURES takes in a word_indices vector and produces a feature vector

%from the word indices

% x = EMAILFEATURES(word_indices) takes in a word_indices vector and

% produces a feature vector from the word indices.

% Total number of words in the dictionary

n = 1899;

% You need to return the following variables correctly.

x = zeros(n, 1);

% ====================== YOUR CODE HERE ======================

% Instructions: Fill in this function to return a feature vector for the

% given email (word_indices). To help make it easier to

% process the emails, we have have already pre-processed each

% email and converted each word in the email into an index in

% a fixed dictionary (of 1899 words). The variable

% word_indices contains the list of indices of the words

% which occur in one email.

%

% Concretely, if an email has the text:

%

% The quick brown fox jumped over the lazy dog.

%

% Then, the word_indices vector for this text might look

% like:

%

% 60 100 33 44 10 53 60 58 5

%

% where, we have mapped each word onto a number, for example:

%

% the -- 60

% quick -- 100

% ...

%

% (note: the above numbers are just an example and are not the

% actual mappings).

%

% Your task is take one such word_indices vector and construct

% a binary feature vector that indicates whether a particular

% word occurs in the email. That is, x(i) = 1 when word i

% is present in the email. Concretely, if the word 'the' (say,

% index 60) appears in the email, then x(60) = 1. The feature

% vector should look like:

%

% x = [ 0 0 0 0 1 0 0 0 ... 0 0 0 0 1 ... 0 0 0 1 0 ..];

%

%

for i = word_indices

x(word_indices) = 1;

endfor

% =========================================================================

end

'Coursera 강의 > Machine Learning' 카테고리의 다른 글

| [Machine Learning] Dimensionality Reduction(PCA) (1) | 2020.08.27 |

|---|---|

| [Machine Learning] Unsupervised Learning 비지도 학습 (0) | 2020.08.25 |

| [Machine Learning] SVM : Kernel (0) | 2020.08.23 |

| [Machine Learning] Support Vector Machine (2) | 2020.08.22 |

| [Machine Learning] Machine Learning System Design (0) | 2020.08.20 |

댓글