References

- 확률과 통계 강의 10, 11, 12, 13강 (KOWC - 한양대학교 이상화 교수님)

- Fundamentals of Applied Probability and Random Processs (Oliver Ibe)

Contents

- Joint & Marginal CDF of Bivariate RVs

- Discrete & Continuous Bivariate RVs

- Conditional Distribution of Bivariate RVs

- Conditional Means & Variances

- Covariance & Correlattion Coefficient

- Multivariate RVs

- Multinomial Distributions

- Joint Gaussian Distributions

Joint CDF of Bivariate RVs

두 개의 확률 변수 X와 Y가 동일한 Sample Space에 정의되어 있다고 가정해봅시다. 예를 들면, X를 학생의 성적이라고 정의하고, Y를 X와 동일한 학생들의 키라고 정의할 수 있습니다. 이때, Joint(결합) CDF는 다음과 같이 정의됩니다.

\[F_{XY}(x, y) = P(\{X \leq x\} \cap \{Y \leq y\}) = P(X \leq x, Y \leq y)\]

여기서 (X, Y) 쌍은 2개의 확률 변수를 가지고 있기 때문에 bivariate random variable이라고 칭합니다.

그리고, 각각의 변수에 대한 CDF를 Marginal(주변) CDF라고 합니다. 위의 경우에는 아래의 두 개의 Marginal CDF가 정의됩니다.

\[\begin{align*} F_X(x) = P(X \leq x) \\ F_Y(y) = P(Y \leq y) \end{align*}\]

Joint CDF(\(F_{XY}(x, y)\))는 다음의 성질들을 만족합니다.

1) \(0 \leq F_{XY}(x, y) \leq 1\)

2) \(x_1 \leq x_2, y_1 \leq y_2\)라면, 다음을 만족함

\[\begin{align*} F_{XY}(x_1, y_1) \leq F_{XY}(x_1, y_2) \leq F_{XY}(x_2, y_2) \\ F_{XY}(x_1, y_1) \leq F_{XY}(x_2, y_1) \leq F_{XY}(x_2, y_2) \end{align*}\]

3) \(\underset{x \rightarrow \infty, y \rightarrow \infty}{\lim} F_{XY}(x, y) = P(X \leq \infty, Y \leq \infty) = 1\)

4) \(\underset{x \rightarrow -\infty}{\lim} F_{XY}(x, y) = P(X \leq -\infty, Y \leq y) = 0\)

5) \(\underset{y \rightarrow -\infty}{\lim} F_{XY}(x, y) = P(X \leq x, Y \leq -\infty) = 0\)

6) \(\underset{x \rightarrow -\infty, y \rightarrow -\infty}{\lim} F_{XY}(x, y) = P(X \leq -\infty, Y \leq -\infty) = 0\)

7) \(F_{XY}(x_1 < x \leq x_2, Y \leq y) = F_{XY}(x_2, y) - F_{XY}(x_1, y)\)

8) \(P(x_1 < X \leq x_2, y_1 < Y \leq y_2) = F_{XY}(x_2, y_2) - F_{XY}(x_2, y_1) - F_{XY}(x_1, y_2) + F_{XY}(x_1, y_1)\)

위 성질들을 이용하여, \(P(X > a, Y >b)\)를 구하면 다음과 같습니다.

\[P(X > a, Y > b) = 1 - F_X(a) - F_Y(b) + F_{XY}(a, b)\]

Discrete Bivariate RVs

X와 Y가 이산 확률 변수일 때, Joint PMF는 다음과 같이 정의됩니다.

\[P(X = x, Y = y) = P_{XY}(x, y)\]

이때, Joint PMF는 다음의 성질들을 만족합니다.

1) \(0 \leq P_{XY}(x, y) \leq 1\)

2) \(\sum_x \sum_y P_{XY}(x, y) = 1\)

3) \(F_{XY}(x, y) = P(X \leq x, Y \leq y) = \sum_{X \leq x} \sum_{Y \leq y} P_{XY}(x, y)\)

그리고, Marginal PMF는 아래의 식으로 얻을 수 있습니다.

\[\begin{align*} P_X(x) = \sum_y P_{XY}(x, y) = P(X = x) \\ P_Y(y) = \sum_x P_{XY}(x, y) = P(Y= y) \end{align*}\]

만약 X와 Y가 서로 독립(independent)라면, 다음의 식이 성립합니다.

\[P_{XY}(x, y) = P_X(x) P_Y(y)\]

동전을 3번 던지는 실험에서 확률 변수 X를 첫 번째 시도에서 H(head)가 나오면 1, T(tail)이 나오면 0이라고 정의하고, 확률 변수 Y를 동전을 3번 던져서 H가 나온 횟수라고 정의해봅시다.

이 실험에서의 Sample Space와 확률 변수의 값은 다음과 같습니다.

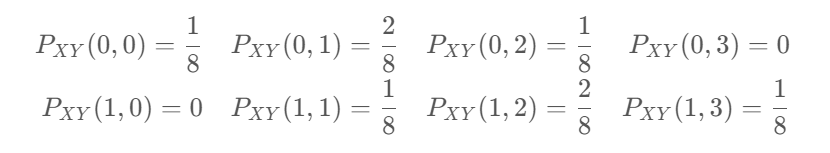

따라서, 모든 x, y에대한 Joint PMF는 다음과 같습니다.

\[\begin{align*} P_{XY}(0, 0) = \frac{1}{8} && P_{XY}(0, 1) = \frac{2}{8} && P_{XY}(0, 2) = \frac{1}{8} && P_{XY}(0, 3) = 0 \\ P_{XY}(1, 0) = 0 && P_{XY}(1, 1) = \frac{1}{8} && P_{XY}(1, 2) = \frac{2}{8} && P_{XY}(1, 3) = \frac{1}{8} \end{align*}\]

이때, 각 확률 변수의 Marginal PMF는 다음과 같습니다.

\[\begin{align*} P_X(0) = \frac{1}{2} && P_X(1) = \frac{1}{2} \\ P_Y(0) = \frac{1}{8} && P_Y(1) = \frac{3}{8} && P_Y(2) = \frac{3}{8} && P_Y(3) = \frac{1}{8} \end{align*}\]

여기서 만약 X와 Y가 독립이라면 모든 x, y에 대해 \(P_{XY}(x, y) = P_X(x)P_Y(y)\)가 성립해야 합니다.

\[P_X(0) P_Y(0) = \frac{1}{2} \times \frac{1}{8} = \frac{1}{16} \neq P_{XY}(0, 0) = \frac{1}{8}\]

위와 같이 등호가 성립하지 않기 때문에 두 확률 변수는 서로 독립이 아닙니다.

Continous Bivariate RVs

연속 확률 변수의 경우에는 PMF를 정의할 수 없기 때문에 PDF를 정의합니다.

두 개의 연속 확률 변수에 대한 Joint PDF는 다음과 같이 정의됩니다.

\[f_{XY}(x, y) = \frac{\partial^2}{\partial x \partial y}F_{XY}(x, y)\]

그리고, 다음과 같은 성질들을 만족합니다.

1) \(f_{XY} \geq 0\)

2) \(\int_{-\infty}^{\infty} \int_{-\infty}^{\infty} f_{XY}(x, y) \mathrm{d}x \mathrm{d}y = F_{XY}(\infty, \infty) = 1\)

3) \(P(x_1 < X \leq x_2, y_1 < Y < y_2) = \int_{y_1}^{y_2} \int_{x_1}^{x_2} f_{XY}(x, y) \mathrm{d}x \mathrm{d}y = F_{XY}(x_2, y_2) - F_{XY}(x_1, y_2) - F_{XY}(x_2, y_1) + F_{XY}(x_1, y_1)\)

이산 확률 변수와 마찬가지로 각각의 연속 확률 변수에 대한 Marginal PDF는 다음과 같이 얻을 수 있습니다.

\[\begin{align*} f_X(x) &= \int_{-\infty}^{\infty} f_{XY}(x, y) \mathrm{d}y \\ f_Y(y) &= \int_{-\infty}^{\infty} f_{XY}(x, y) \mathrm{d}x \end{align*}\]

또한, 두 확률 변수 X, Y가 서로 독립(independent)라면 다음의 식이 성립하게 됩니다.

\[f_{XY}(x, y) = f_X(x)f_Y(y)\]

연속 확률 변수의 Joint PDF의 정의를 살펴보면, Joint CDF를 두 확률 변수에 대해 편미분한 것과 같습니다. 확률 변수가 하나일 때, PDF는 물리적으로 단위 길이 당 확률을 의미했습니다. 하지만 확률 변수가 2개가 되면 Joint PDF는 확률 밀도(단위 면적 당 확률)를 의미하게 됩니다.

Contional Distribution for Bivariate RVs

Discrete Bivariate RVs

먼저 이산 확률 변수에 대한 조건부 분포를 생각해봅시다.

조건부 확률은 사건들(events)의 집합으로 고려했을 때, 다음과 같이 표현합니다.

\[P(A|B) = \frac{P(A \cap B)}{P(B)}\]

그리고 확률 변수를 통해서 표현할 때 일반적으로 다음과 같이 표현합니다.

\[P(X \leq x | X \leq a) = F_X(x | X \leq a)\]

두 개의 확률 변수일 때도 이와 동일합니다. 만약 \(X = x\)로 주어진 경우, \(Y\)의 조건부 PMF는 다음과 같이 구할 수 있습니다.

\[P_{Y|X} (Y = y | X = x) = \frac{P(X = x, Y = y)}{P(X = x)} = \frac{P_{XY}(x, y)}{P_{XY}(x)}\]

예를 들어, 위에서 살펴본 동전을 3번 던지는 실험을 고려해봅시다. 확률 변수 X와 Y의 정의는 동일하다고 가정합니다.

이때, Joint PMF와 Marginal PMF는 다음과 같습니다.

이때, \(P_{Y|X}(Y = 1|X = 0)\)은 다음과 같이 계산할 수 있습니다.

\[P_{Y|X}(Y=1|X=0) = \frac{P_{XY}(0, 1)}{P_X(0)} = \frac{2/8}{1/2} = \frac{2}{4}\]

Continuous Bivariate RVs

두 연속 확률 변수에 대한 조건부 확률, 예를 들어, \(X = x\)로 주어졌을 때 Y의 조건부 PDF는 다음과 같이 정의됩니다.

\[f_{Y|X}(y|x) = \frac{f_{XY}(x, y)}{f_X(x)}\]

여기서 \(X = x\)로 주어졌다는 것에 주의할 필요가 있습니다. 일반적으로 연속 확률 분포에 대해 하나의 특정한 값에 대한 확률은 0이라고 알고 있습니다. 이 때문에 조금 헷갈릴 수 있습니다.

쉽게 말하면, 두 확률 변수는 이제 평면 상에서 표현할 수 있습니다. 이때, \(X = x\)라고 고정하면 이에 해당하는 \(Y\)의 범위가 형성되고 이 범위에 대한 확률이 바로 \(X = x\)일 때의 Y의 조건부 확률이 되는 것입니다.

조건부 PDF를 식으로 정리하면, 다음과 같습니다.

\[\begin{align*} f_{Y|X}(y|x) &= \frac{\partial}{\partial y}F_{Y|X}(y | X = x) \\ &= \frac{\partial}{\partial y} P_{Y|X}(Y \leq y | X = x) \\ &= \frac{\partial}{\partial y} \frac{P(Y \leq Y, X = x)}{P(X = x)} \end{align*}\]

분자나 분모에 \(X = x\)에 대한 확률이 포함되어 있기 때문에 \(0/0\)의 꼴이 되고, 미분 개념으로 생각하면 그 결과가 의미있는 값이 될 수 있다는 것을 알 수 있습니다.

따라서, 위의 식을 이어서 극한을 적용하면,

\[\begin{align*} &= \frac{\partial}{\partial y} \lim_{\Delta x \rightarrow 0} \frac{P(Y \leq y, x < X \leq x + \Delta x}{P(x < X \leq x + \Delta x} \\ &= \frac{\partial}{\partial y} \lim_{\Delta x \rightarrow 0} \frac{F_{XY}(x + \Delta x, y) - F_{XY}(x, y)}{F_X(x + \Delta x) - F_X(x)} \\ &= \frac{\partial}{\partial y} \lim_{\Delta x \rightarrow 0} \frac{(F_{XY}(x + \Delta x, y) - F_{XY}(x, y)) / \Delta x}{(F_X(x + \Delta x) - F_X(x)) / \Delta x} \\ &= \frac{\partial}{\partial y} \frac{\frac{\partial}{\partial x}F_{XY}(x, y)}{f_X(x)} = \frac{\frac{\partial ^2}{\partial x \partial y}F_{XY}(x, y)}{f_X(x)} \\ &= \frac{f_{XY}(x, y)}{f_X(x)} \end{align*}\]

이 성립합니다.

즉, 두 연속 확률 변수에 대한 조건부 PDF는 다음과 같이 Joint PDF와 Marginal PDF로 계산할 수 있습니다.

\[\begin{align*} f_{Y|X}(y|x) &= \frac{f_{XY}(x, y)}{f_X(x)} \\ f_{X|Y}(x|y) &= \frac{f_{XY}(x, y)}{f_Y(y)} \end{align*}\]

만약 두 확률 변수가 서로 독립이라면, 다음의 식이 성립합니다.

\[f_{X|Y}(x|y) = f_X(x) \text{ AND } f_{Y|X}(y|x) = f_Y(y)\]

Contional Means & Variances

확률 변수의 평균과 분산

References 확률과 통계 강의 5, 6강 (KOWC - 한양대학교 이상화 교수님) Fundamentals of Applied Probability and Random Processs (Oliver Ibe) Contents 평균, 기댓값 (Expectation) 분산 (Variance) 조건부..

junstar92.tistory.com

하나의 확률 변수에 대한 조건부 평균은 다음과 같이 정의됩니다.

\[E[X | X \leq a] = \int_{x \leq a} xf_X(x|x \leq a) \mathrm{d}x\]

두 개의 확률 변수에 대한 확률은 조건부 확률과 비슷하게 \(E[Y|X =x]\)로 표현할 수 있는데, 결과적으로 이 확률은 \(g(x)\)와 같이 x에 대한 함수(또는 상수)로 표현될 것 입니다. 즉, x의 값에 의해서 Y의 평균이 결정된다는 것을 의미합니다.

두 확률 변수가 이산 확률 변수라면, 다음과 같이 평균과 분산이 계산되고

\[\begin{align*} \mu_{Y|X} &= E[Y|X = x] = \sum_y yP_{Y|X}(y|x) \\ \sigma_{Y|X}^2 &= E[Y^2|X=x] - \mu_{Y|X}^2 \end{align*}\]

두 확률 변수가 연속 확률 변수라면, 평균은 다음과 같이 계산됩니다.

\[\begin{align*} \mu_{Y|X} &= E[Y|X=x] = \int_{-\infty}^{\infty} y f_{Y|X}(y|x) \mathrm{d}y \end{align*}\]

Ex 5.10>

\(f_{XY}(x, y) = \begin{cases} \frac{e^{-x/y} e^{-y}}{y} && 0 \leq x \infty, 0 < y < \infty \\ 0 && \text{otherwise} \end{cases}\)

Joint PDF가 위와 같이 주어졌을 때, \(E[X|Y=y]\)를 계산해보도록 하겠습니다.

먼저 조건부 평균을 계산하려면 conditional PDF \(f_{X|Y}(x|y)\)를 알아야 하는데, 조건부 PDF는 Joint PDF와 Marginal PDF의 식으로 구할 수 있기 때문에, 먼저 marginal PDF \(f_Y(y)\)를 계산해야 합니다.

\(f_Y(y) = \int_{0}^{\infty} f_{XY}(x, y)\mathrm{d}x = \int_{0}^{\infty} \frac{e^{-x/y}e^{-y}}{y} \mathrm{d}x = \frac{e^{-y}}{y} \int_{0}^{\infty} e^{-x/y}\mathrm{d}x = e^{-y}\)

\(f_{X|Y}(x|y) = \frac{f_{XY}(x, y)}{f_Y(y)} = \frac{e^{-x/y}e^{-y}}{ye^{-y}} = \frac{1}{y}e^{-x/y}\)

위 식에 의해서 조건부 평균은 다음과 같이 계산할 수 있습니다.

\(E[X|Y=y] = \int_{0}^{\infty} x f_{X|Y}(x|y)\mathrm{d}x = \frac{1}{y} \int_{0}^{\infty} x e^{-x/y} \mathrm{d}x\)

여기서 \(u = x\)로 치환하고, \(v = -ye^{-x/y}\)로 치환하여 부분적분 법으로 계산하면, 조건부 평균 \(E[X|Y=y]\)는 다음과 같이 계산됩니다.

위에서 언급했던 것처럼 y에 대한 식으로 계산된 것을 확인할 수 있습니다.

어떤 확률 변수 X를 g(X)로 매핑했을 때, \(E[g(X)]\)는 어떻게 계산될까요?

원래 X에 대한 평균을 계산하는 식에 X 대신 g(X)로만 바꿔주면 됩니다.

\[E[g(X)] = \int g(x)f_X(x) \mathrm{d}x\]

두 개의 확률 변수 X, Y를 어떤 변환 함수 \(h(X, Y)\)로 매핑했을 때도 동일합니다.

\[E[h(X, Y)] = \int \int h(x, y) f_{XY}(x, y) \mathrm{d}x \mathrm{d}y\]

이에 대해서는 6장에서 조금 더 자세하게 다루겠지만, 이번 포스팅에서 간단하게 \(E[E[X|Y]]\)가 어떻게 계산되는지만 살펴보겠습니다.

\[\begin{align*} E[E[X|Y]] &= E[\int x f_{X|Y}(x|Y=y) \mathrm{d}x] \end{align*}\]

오른쪽 항을 살펴보면, 결국 \(\int x f_{X|Y}(x|Y=y) \mathrm{d}x\)는 y에 대한 식 \(g(y)\)의 꼴이 될 것이기 때문에 \(E[g(y)]\)를 구하는 것과 동일합니다. 위의 식을 이어서 풀어보면,

\[\begin{align*} E[E[X|Y]] &= E[\int x f_{X|Y}(x|Y=y) \mathrm{d}x] \\ &= \int \left ( \int x f_{X|Y}(x|y)\mathrm{d}x \right )f_Y(y) \mathrm{d}y \\ &= \int \int x \frac{f_{XY}(x, y)}{f_Y(y)} f_Y(y) \mathrm{d}x \mathrm{d}y \\ &= \int \int x f_{XY}(x, y) \mathrm{d}y \mathrm{d}x \\ &= \int x f_X(x) \mathrm{d}x = E[X] \end{align*}\]

\(E[E[X|Y]] = E[X]\)라는 것을 알 수 있습니다.

Covariance & Correlation Coefficient

두 개의 확률 변수 X, Y에 대한 공분산(covariance)와 상관 계수(correlation coefficient)는 두 확률 변수가 얼마나 비슷한 경향으로 발생하는지 보여줍니다. 다르게 표현하면 두 확률 변수가 선형 관계에 있는지 보여줍니다.

두 확률 변수 X, Y에 대해서 기댓값이 각각 \(E[X] = \mu_X, E[Y] = \mu_Y\)이고, 분산이 \(\sigma_X^2, \sigma_Y^2\)인 경우, X와 Y의 공분산은 \(\text{Cov}(X, Y)\) 또는 \(\sigma_{XY}\)로 표기하며 다음과 같이 정의됩니다.

\[\begin{align*} \text{Cov}(X, Y) &= \sigma_{XY} = E[(X-\mu_X)(Y-\mu_Y)] \\ &= E[XY - \mu_Y X - \mu_X Y + \mu_X \mu_Y] \\ &= E[XY] - \mu_Y E[X] - \mu_X E[Y] + \mu_X \mu_Y \\ &= E[XY] -\mu_X \mu_Y - \mu_X \mu_Y + \mu_X \mu_Y \\ &= E[XY] - \mu_X \mu_Y \end{align*}\]

이때, \(\text{Cov}(X, Y) = 0\)이라면, 두 확률 변수 X와 Y는 서로 uncorrelated라고 합니다. 즉, 각 확률 변수는 서로 연관이 없으며, 즉, \(Y = g(X)\)로 매핑해주는 특정 변환 함수 \(g(X)\)가 존재하지 않는다고 할 수 있습니다.

반대로 두 확률 변수가 서로 correlated하다면, 서로 연관되어 있고 \(Y = g(X)\)로 매핑해주는 변환 함수가 존재한다는 것을 의미합니다.

만약 두 확률 변수가 서로 독립(independent)라면 어떻게 될까요?

두 확률 변수가 독립이려면 \(f_{XY}(x, y) = f_X(x) f_Y(y)\)가 만족해야 합니다.

두 확률 변수가 독립일 때, 공분산의 정의를 조금 더 풀어보면

\[\begin{align*} \text{Cov}(X, Y) &= E[XY] - \mu_X \mu_Y \\ &= \int \int xy f_{XY}(x, y) \mathrm{d}x \mathrm{d}y - \mu_X \mu_Y \\ &= \int x f_X(x) \mathrm{d}x \int y f_Y(y) \mathrm{d}y - \mu_X \mu_Y \\ &= \mu_X \mu_Y - \mu_X \mu_Y = 0 \end{align*}\]

이 성립합니다.

따라서, 두 확률 변수가 서로 독립이라면 공분산이 0이 되므로 서로 correlated하다고 할 수 있습니다.

하지만 두 확률 변수가 서로 correlated하다고 해서 서로 독립인 경우는 아니므로 주의해야 합니다. 즉, 반대의 경우에는 항상 성립하지 않습니다.

결과적으로 uncorrelated 조건이 조금 더 상위 조건에 속하며, 독립 조건은 uncorrelated 조건 하위에 존재한다고 볼 수 있습니다.

X와 Y의 공분산을 구하면, 상관 계수(correlation coefficient)를 정의할 수 있으며 \(\rho(X, Y)\) 또는 \(\rho_{XY}\)로 표기합니다.

\[\rho_{XY} = \frac{\text{Cov}(X, Y)}{\sqrt{\text{Var}(X)\text{Var}(Y)}} = \frac{\sigma_{XY}}{\sigma_X \sigma_Y}\]

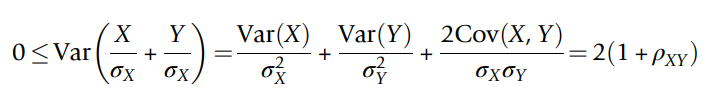

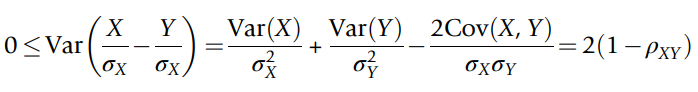

상관 계수 값의 범위는 \(-1 \leq \rho_{XY} \leq 1\) 이며, 분산은 항상 음수가 아니기 때문에 아래의 식들을 통해서 유도할 수 있습니다.

(Cauchy-Schwarz Inequality를 통해서 증명할 수도 있습니다)

예를 들어, 두 확률 변수 X, Y가 \(Y = aX + b, a > 0, b \neq 0\)의 관계를 가지고 있다고 가정해봅시다.

그렇다면, 공분산 \(\sigma_{XY}\)는

\[\begin{align*} \sigma_{XY} &= E[(X-\mu_X)(Y-\mu_Y)] \\ &= E[(X-\mu_X)(aX+b - (a\mu_X + b))] \\ &= E[(X-\mu_X)(aX - a\mu_X)] \\ &= aE[(X-\mu_X)^2] = a \sigma_X^2 \end{align*}\]

위의 식에 의해서 \(a\sigma_X^2\)가 됩니다. 그리고 X와 Y의 분산은 \(\sigma_Y^2 = a^2 \sigma_X^2\)의 관계를 갖습니다. 따라서, X와 Y의 상관 계수 \(\rho_{XY}\)는

\[\rho_{XY} = \frac{a \sigma_X^2}{\sigma_X |a|\sigma_X}\]

가 되며, a가 양수라면 이 값은 1, a가 음수라면 이 값은 -1이 되는 것을 확인할 수 있습니다.

(X와 Y가 정확히 1:1 대칭이 되기 때문에 이렇게 상관 계수가 1 또는 -1이 되는 것을 확인할 수 있습니다)

만약 \(Y = X^2\)의 관계를 갖는다면, 이 상관 계수는 1이 아니라 1보다 떨어지는 값이 됩니다.

Multivariate Random Variables

지금까지는 2개의 확률 변수를 고려했습니다. 이번에는 2개 이상의 확률 변수에 대해 고려해보도록 하겠습니다.

동일한 Sample Space에 정의된 확률 변수의 집합 \(X_1, X_2, \cdots, X_n\)이 있다고 가정해봅시다. 이때, 이 확률 변수들의 joint CDF는 다음과 같이 정의됩니다.

\[F_{X_1, X_2, \cdots, X_n} = P(X_1 \leq x_1, X_2 \leq x_2, \cdots, X_n \leq x_n)\]

만약 모든 확률 변수들이 이산 확률 변수라면, 이들의 joint PMF는 다음과 같이 정의됩니다.

\[P_{X_1, X_2, \cdots, X_n} = P(X_1 = x_1, X_2 = x_2, \cdots, X_n = x_n)\]

모든 확률 변수들이 연속 확률 변수라면, joint PDF가 다음과 같이 정의됩니다.

\[f_{X_1, X_2, \cdots, X_n} = \frac{\partial ^n}{\partial x_1 \partial x_2 \cdots \partial x_n}F_{X_1, X_2, \cdots, X_n}(x_1, x_2, \cdots, x_n)\]

조건부 PDF는 다음과 같이 정의됩니다.

\[f_{X_n| X_{n-1}, X_{n-2}, \cdots, X_1}(x_n | x_{n-1}, x_{n-2}, \cdots, x_1) = \frac{f_{X_1 X_2 \cdots X_n}(x_1, x_2, \cdots, x_n)}{f_{X_1 X_2 \cdots X_{n-1}}(x_1, x_2, \cdots, x_{n-1})}\]

Multinomial Distributions

이항 분포(binomial distribution)은 2가지 결과가 가능한 사건을 n번 시도했을 때, k번 발생할 확률에 대한 확률 분포입니다. 즉, 2가지 경우에 대한 확률 분포이며, 그 확률은 다음과 같이 정의됩니다.

\[P(k) = \binom{n}{k}p^k(1-p)^{n-k}\]

다항 분포(multinomial distribution)는 이항 분포의 확장이며, m가지 결과가 가능한 사건을 n번 시도했을 때의 확률 분포이며 다음과 같이 정의됩니다.

\[\begin{align*} P_{K_1, K_2, \cdots, K_m}(k_1, k_2, \cdots, k_m) &= P(K_1 = k_1, K_2 = k_2, \cdots, K_m = k_m) \\ &= \binom{n}{k_1 k_2 \cdots k_m} p_1^{k_1} p_2^{k_2} \cdots p_m^{k_m} \\ &= \frac{n!}{k_1! k_2! \cdots k_m!}p_1^{k_1} p_2^{k_2} \cdots p_m^{k_m} \end{align*}\]

이때, \(\sum_{i=1}^{m} k_i = n\)이며, \(k_i = 0, 1, \cdots, n \text{ for } i = 1, 2, \cdots, m\) 입니다. \(m = 2\)인 경우, 다항 분포는 이항 분포에 해당됩니다.

Joint Gaussian Distribution

Joint Gaussian Distribution은 연합 정규 분포라고도 부르며, 우리가 잘 알고 있는 정규 분포에서 확률 변수의 갯수를 증가시킨 버전이라고 볼 수 있습니다.

2개의 확률 변수에 대한 연합 정규 분포는 다음과 같이 정의됩니다.

\[f_{XY}(x, y) = \frac{1}{2\pi \sigma_X \sigma_Y \sqrt{1 - \rho^2}} \text{exp}\left \{ -\frac{1}{2(1-\rho^2)} \left [ \frac{(x-\mu_X)^2}{\sigma_X^2} -\frac{2\rho (x-\mu_X)(y - \mu_Y)}{\sigma_X \sigma_Y} + \frac{(y-\mu_Y)^2}{\sigma_Y^2} \right ] \right \}\]

이때, \(\mu_X, mu_Y\)는 각 확률 변수의 평균, \(\sigma_X^2, \sigma_Y^2\)은 각 확률 변수의 분산, \(\rho\)는 두 확률 변수의 상관 계수입니다.

만약, X와 Y가 서로 상관되지 않는다면(uncorrelated), \(rho = 0\) 이며, 따라서,

\[f_{XY}(x, y) = f_X(x) \cdot f_Y(y) = \frac{1}{\sqrt{2 \pi \sigma_X^2}}e^{-\frac{(x-\mu_X)^2}{2\sigma_X^2}} \frac{1}{\sqrt{2\pi \sigma_Y^2}} e^{-\frac{(y-\mu_Y)^2}{2\sigma_Y^2}}\]

가 되며, X와 Y(marginal density)가 각각 정규분포이며 서로 독립이라는 것을 확인할 수 있습니다.

(연합 정규 분포의 상관 계수가 0이면, X와 Y는 서로 독립이라는 명제가 참이 됩니다.)

2개가 아닌 2개 이상의 확률 변수에 대한 가우시안 분포는 다음과 같이 정의됩니다.

\[f_{X_1,X_2,\cdots, X_N}(x_1, x_2, \cdots, x_N) = \frac{ | \mathbb{C}^{-1} |^{ \frac{1}{2} }}{ (2\pi)^{ \frac{N}{2} }} \text{exp} \left \{ - \frac{[X- \overline{X}]^\top \mathbb{C}_X^{-1} [X-\overline{X}]}{2} \right \}\]

위 식에서 \([X-\overline{X}]\)는

\[\begin{bmatrix} X_1 - \mu_{X_1} \\ X_2 - \mu_{X_2} \\ \vdots \\ X_N - \mu_{X_N} \end{bmatrix}\]

이며,

\(\mathbb{C}_X\)는 covariance matrix로,

\[\begin{bmatrix} C_{11} && C_{12} && \cdots && C_{1N} \\ C_{21} && && \cdots && \\ \cdots && && \cdots && \\ C_{N1} && && \cdots && C_{NN} \end{bmatrix}\]

이며, 각 요소 \(C_{ij}, C_{ii}\)는

\[C_{ij} = E[(X_i - \mu_{X_i})(X_j - \mu_{X_j})], C_{ii} = \sigma_{X_i}^2\]

로 정의됩니다.

'ML & DL > 확률과 통계' 카테고리의 다른 글

| Transform Methods (0) | 2022.06.24 |

|---|---|

| Functions of Random Variables (0) | 2022.06.23 |

| 확률 분포 (Probability Distribution) (0) | 2022.05.30 |

| 확률 변수의 평균과 분산 (0) | 2022.05.28 |

| 확률 변수 (Random Variables) (0) | 2022.05.26 |

댓글